★ ★ 만약 VR 기기가 아직 없다면 XR Device Simulator도 임포트 하자 ★ ★

(이떄 본인은 VR기기 대신 컴퓨터(XR Device Simulator)를 사용해서 진행하였다.)

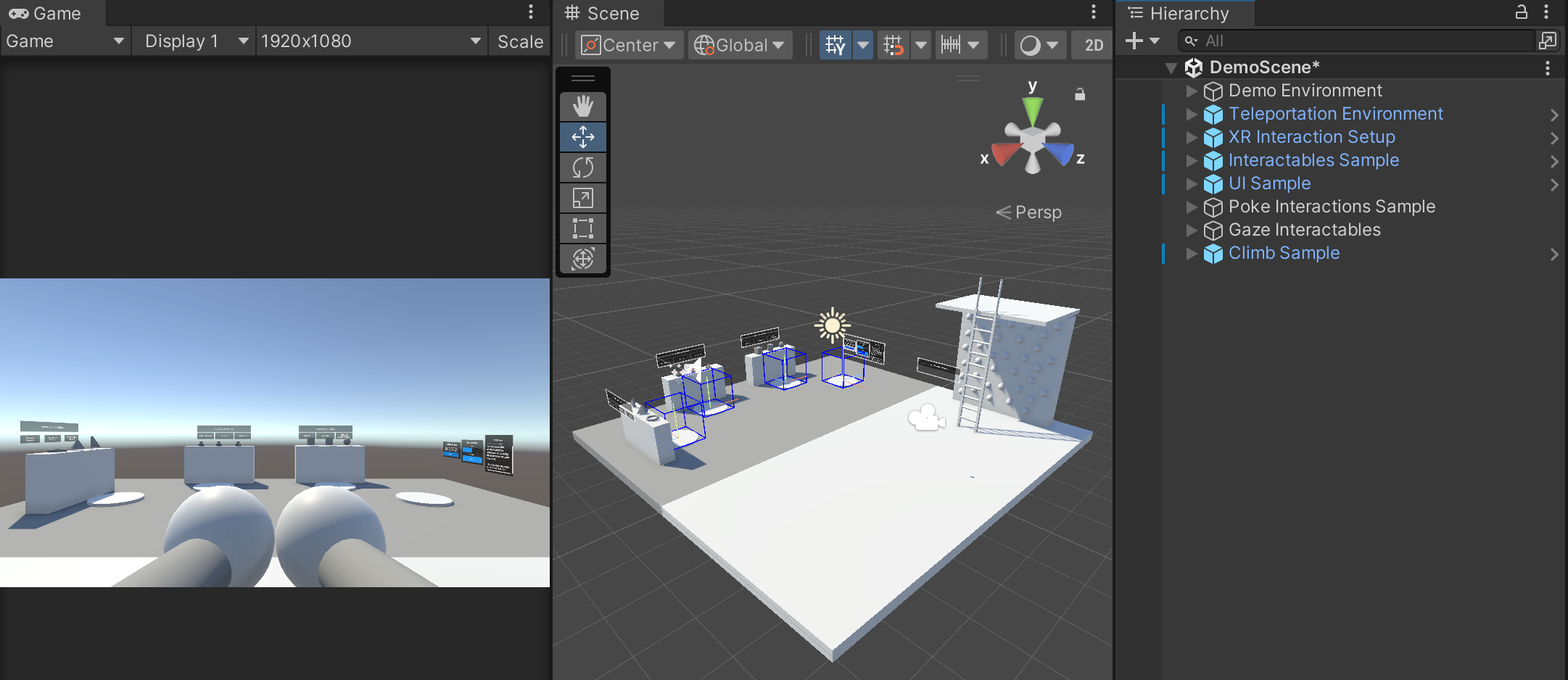

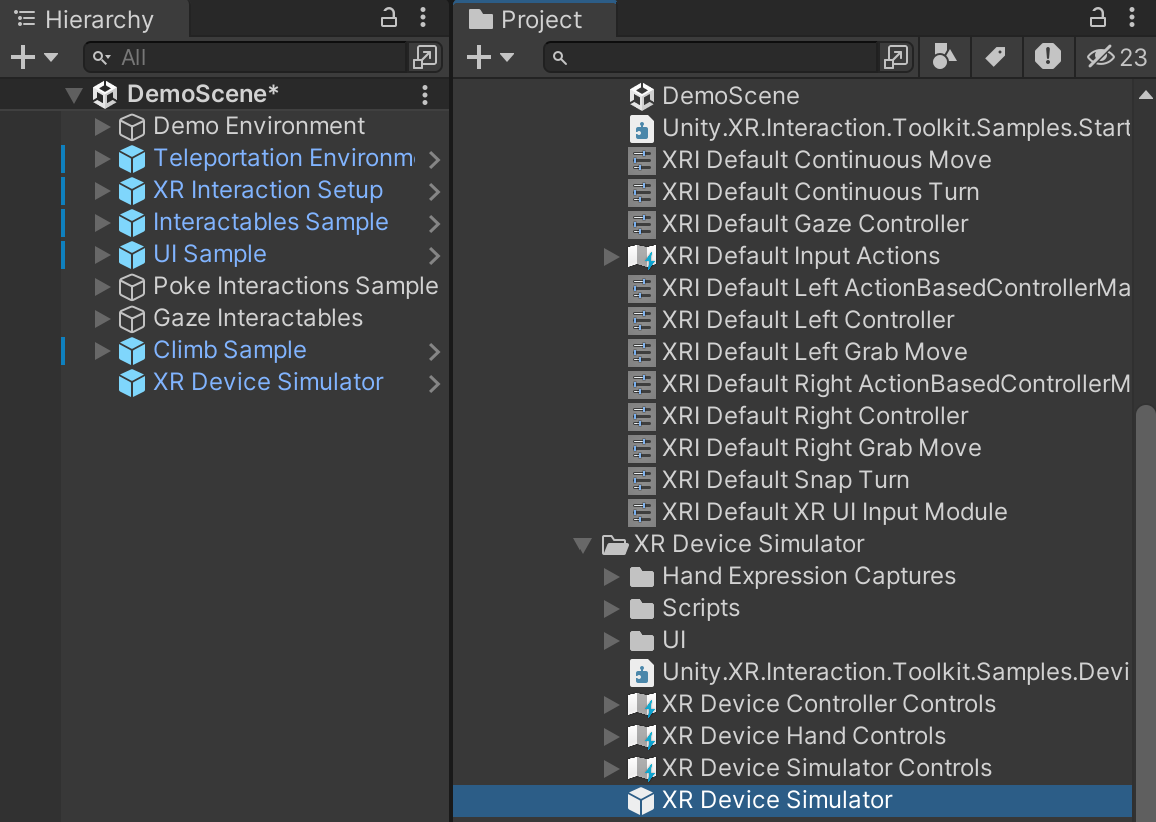

14. XR Device Simulator 프리팹 인스턴스로 생성

Hierarchy에 XR Device Simulator 프리팹을 그대로 드래그하여 생성

→ VR이 하는 대부분의 제스처들을 따라 할 수 있게 됨

컨트롤러 움직이기, Trigger 버튼, Grip 버튼, HMD 움직이기 등

아직 왼손/오른손 컨트롤러가 하는 일은 하지 못함

→ 따로 오브젝트를 추가해줘야 함

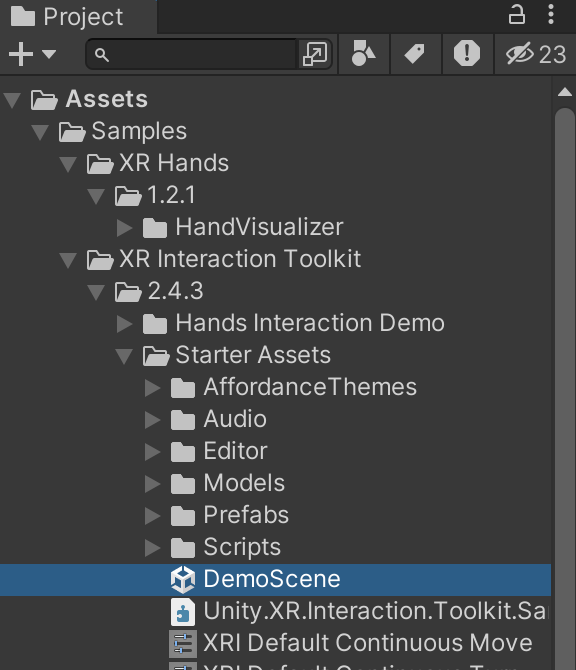

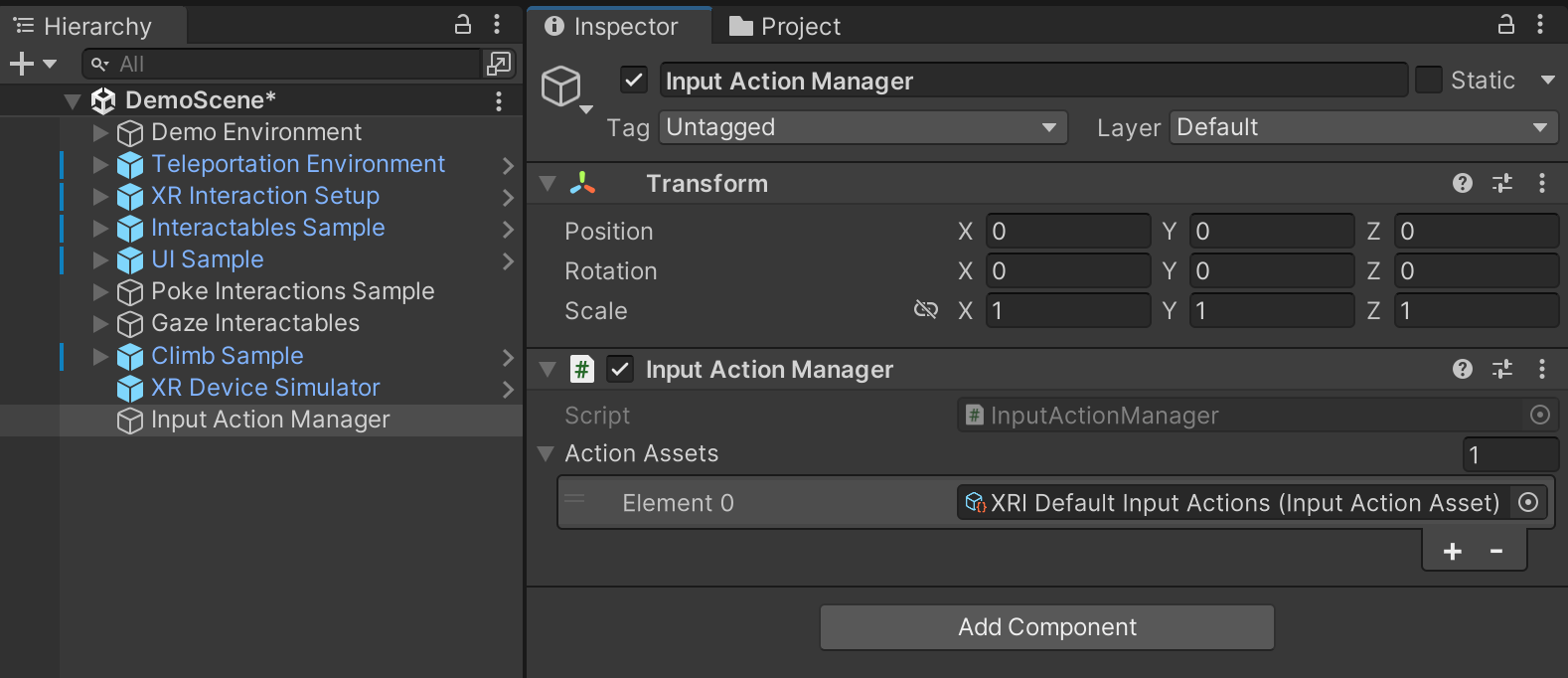

빈 오브젝트를 하나 만들어 Input Action Mananger 스크립트를 컴포넌트로 추가 후,

Action Assets에 XRI Default Input Action을 넣는다.

→ 왼쪽/오른쪽 컨트롤러의 기능을 사용할 수 있게 됨

Tab 키를 눌러서 양쪽 -> 왼쪽 -> 오른쪽 -> 양쪽 순으로 조작 시점 변경이 가능하다.

물체에 Ray를 맞춰서 파란색이 되면 키보드 G키를 통해 Grab이 가능하다.

<결론 및 느낀점>

XR Device Simulator로 컴퓨터를 통해서 조작 하는 것은 가능은 하지만

매우 불편하다.

따라서 관련 작업을 할 때,

VR기기의 필요성이 크게 느껴진다.

반응형

'XR 공부' 카테고리의 다른 글

| 오큘러스 SDK 설치해보기 + 링크를 통해 씬 실행 및 테스트 (0) | 2024.02.06 |

|---|